Data Warehouse

-

High-performance Data Vault

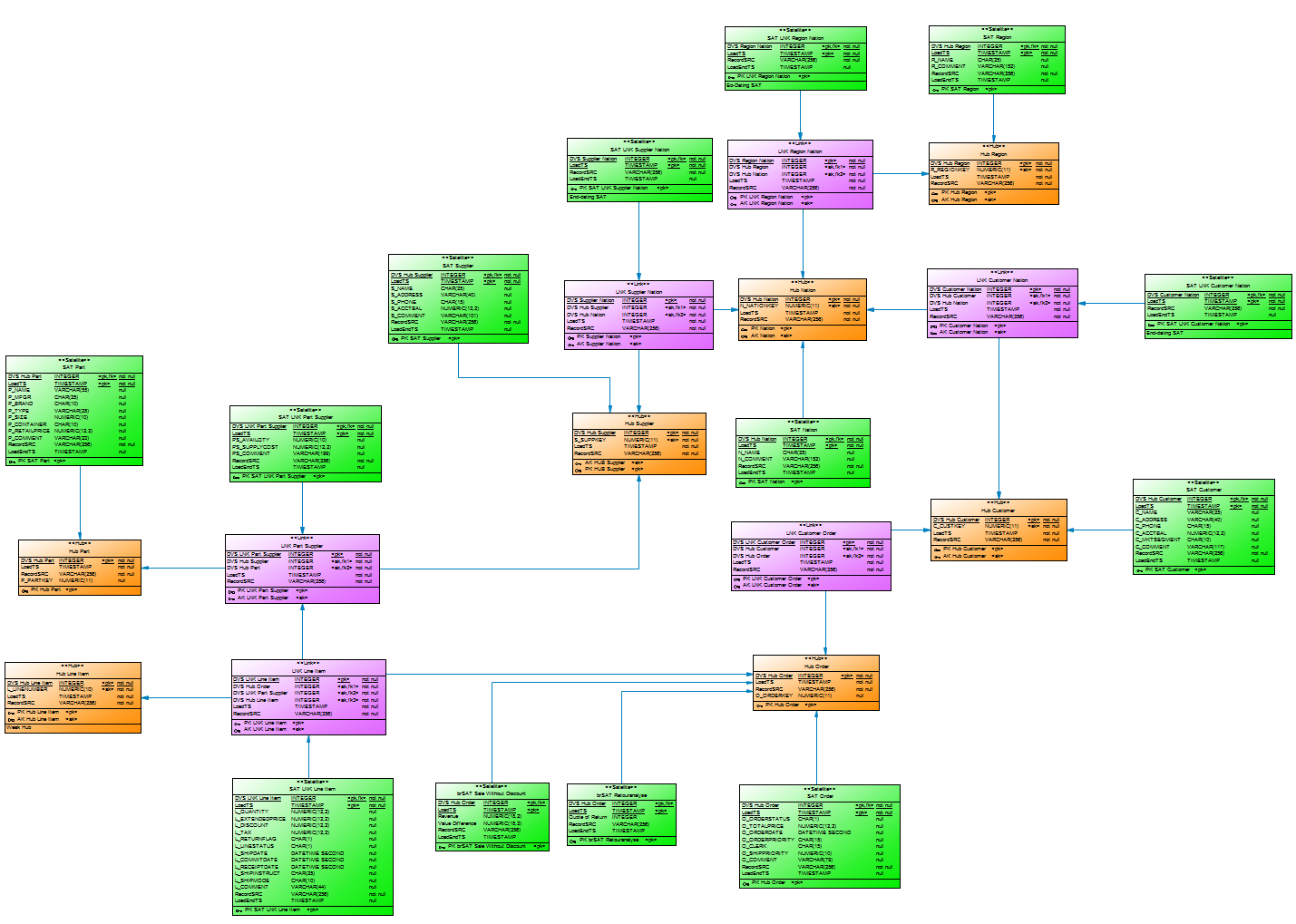

Over the last few weeks, Mathias Brink and I have worked hard on the topic of Data Vault on EXASOL.

Our (simple) question: How does EXASOL perform with Data Vault?

First, we had to decide what kind of data to run performance tests against in order to get a feeling for the power of this combination. And we decided to use the well-known TPC-H benchmark created by the non-profit organisation TPC.

Second, we built a (simple) Data Vault model and loaded 500 GB of data into the installed model. And to be honest, it was not the best model. On top of it we built a virtual TPC-H data model to execute the TPC-H SQLs in order to analyse performance.

-

How to choose a timestamp for a Data Vault timeline?

Does the Load Date Timestamp (LDTS) data element in the hub, link, or satellite capture the timestamp of the batch, or rather the transaction timestamp at which the data originated in the operational system?

-

How to load easy some data vault test data

Some time ago a customers asked me how to load easy and simple some (test)data into their database XYZ (chose the one of your choice and replace XYZ) to test their new developed Data Vault logistic processes.

The point was: They don’t want to use all this ETL-tool and IT-processes overhead just to some small test in their own environment. If this this is well done from a data governance perspective? Well, that’s not part of this blogpost. Just do this kind of thingis only in your development environment. -

Increased quality and sped up process

Dirk Lerner was engaged to coach my efforts of creating a data warehouse using data vault 2.0 architecture. It has been a pleasure to work with Dirk.

-

Lost data mapping on views

FastChangeCoTM's data modelers keep experiencing the problem of lost mappings from views to tables in PowerDesigner.

-

Maßgebliche Verbesserung des Entwicklungsprozesses

Dirk Lerner ist mit seiner Expertise als Coach für Data Vault und flexiblen Data Warehouse Architekturen uneingeschränkt zu empfehlen.

-

Meetup – Data Vault Interest Group

I reactivated my Meetup Data Vault Interest Group this week. Long time ago I was thinking about a table of fellow regulars to network with other, let’s call them Data Vaulters. It should be a relaxed get-together, no business driven presentation or even worse advertisement for XYZ tool, consulting or any flavor of Data Vault. The feedback of many people was that they want something different to the existing Business Intelligence Meetings. So, here it is!

-

Mehr Qualität und beschleunigte Prozesse

Dirk Lerner wurde damit beauftragt, mich bei der Erstellung eines Data Warehouse unter Verwendung der Data Vault 2.0 Architektur zu unterstützen.Es war ein Vergnügen, mit Dirk zu arbeiten.

-

Methodik zur Lösung bitemporaler Aufgaben

Dirk hat eine sehr gut strukturiertes Training über temporale Daten durchgeführt. Er hat mir sehr geholfen, mein Wissen über dieses anspruchsvolle Thema zu erweitern.

-

Methodology to handle bitemporal challenges

Dirk provided a very well structured training on temporal data. He helped me a lot to increase my knowledge about this challenging topic.

-

Model driven decision making @ #BAS19

FastChangeCo and the Fast Change in a Hybrid Cloud Data Warehouse with elasticity

What is this 20 minute talk about at #BAS19?

The fictitious company FastChangeCo has developed a possibility not only to manufacture Smart Devices, but also to extend the Smart Devices as wearables in the form of bio-sensors to clothing and living beings. With each of these devices, a large amount of (sensitive) data is generated, or more precisely: by recording, processing and evaluating personal and environmental data.

-

Model-Driven Decision Making

FastChangeCo - ein anpassungsfähiges Data-Warehouse für schnelle Veränderungen

Das fiktive Unternehmen FastChangeCo hat eine Möglichkeit entwickelt, nicht nur Smart Devices herzustellen, sondern auch die Smart Devices als Wearables in Form von Bio-Sensoren auf Kleidung und Lebewesen auszudehnen. Bei jedem dieser Geräte entsteht eine große Menge an (sensiblen) Daten, genauer gesagt: durch die Aufzeichnung und Aufbereitung sowie die Auswertung personen- und umweltbezogener Daten. -

Model-Driven Decision Making

FastChangeCo - an adaptable data warehouse for rapid changes

The fictitious company FastChangeCo has developed a way not only to manufacture smart devices, but also to extend smart devices to clothing and living beings as wearables in the form of bio-sensors. Each of these devices generates a large amount of (sensitive) data, more precisely: through the recording, processing and analysis of personal and environmental data. -

Modeling the Agile Data Warehouse with Data Vault

Dieses Buch ist ein MUSS für alle, die an Data Vault interessiert sind und auch für alle die sich für Business Intelligence und (Enterprise) Data Warehouse begeistern.

Es ist aus meiner Sicht toll geschrieben: leicht verständlich und es sind alle Themen rund um Data Vault sehr gut erklärt. -

PowerDesigner Serie

/ SECRET SPICE - PowerDesigner Serie

Tipps und Tricks rund um PowerDesigner

In loser Folge berichte ich hier über meinen Erkenntnisgewinn mit dem Datenmodellierungswerkzeug PowerDesigner. Für mich selbst ist diese Serie eine Art Tagebuch, eine Wissensbasis und das ‘Secret Spice’, in der ich meine Entdeckungen, meine für mich selbst dokumentierten Tipps und Tricks rund um den PowerDesigner festhalte: Für Probleme des oder mit dem PowerDesigner, die ich während der Bearbeitung von Aufgaben in der Datenmodellierung hatte.

Erwartet hier daher keine Neuigkeiten über das Datenmodellierungswerkzeug PowerDesigner selbst.

Natürlich, und wie immer, aus meiner persönlichen Sicht oder aus Sicht einer der Team-Mitglieder des Data Management Center of Excellence (DMCE) bei meinem liebsten Kunden: FastChangeCo!

-

PowerDesigner series

/ SECRET SPICE - PowerDesigner SerieS

Tips and tricks for PowerDesigner

In loose order I report here about my gain of knowledge with the data modeling tool PowerDesigner. For myself, this series is a kind of diary, a knowledge base and the 'Secret Spice', in which I record my discoveries, my tips and tricks around PowerDesigner documented for myself: For problems of or with PowerDesigner that I had while working on data modeling tasks.

So don't expect any news here about the data modeling tool PowerDesigner itself.

Of course, and as always, from my personal point of view or from the point of view of one of the team members of the Data Management Center of Excellence (DMCE) at my favorite customer: FastChangeCo!

-

Reflections on Data Natives conference, October 2016

A conference for the data-driven generation!

It’s late October 2016, an incredible crowd of young data-driven peeps are on their way to Berlin, looking forward to meet many other peeps with the same attitude at the Data Natives conference: Doing business with data or seeing a huge value in using data for the future. Besides the crowd I was not only impressed by the location but also by the amount of startups at the conference.

The schedule for two days was full packed with talks and it wasn’t easy to choose between all these interesting topics. So I decided not to give myself too much pressure. Instead I cruised through the program, and stumbled on some highlights.

-

Rückblick auf den 38. TDWI Roundtable in Frankfurt

Unser Roundtable in Frankfurt im März ist mit einem Knaller gestartet:

Marketing für BI ist doch in der Rangfolge noch hinter der Dokumentation.

-

Secret Spice

-

Shared Data in einer virtuellen Architektur

Hybrides Data Warehouse am Beispiel von Data Vault

In der heutigen BI-Welt müssen Anforderungen der Fachbereiche und gesetzliche Vorgaben sowie die Wünsche der Nutzer von Smart Devices an personenbezogenen Daten in Einklang gebracht werden. Anhand des fiktiven Unternehmens FastChangeCo sollen im Folgenden die Herausforderungen an den Schutz der Daten sowie die Umsetzung aufgezeigt werden. FastChangeCo hat eine Möglichkeit entwickelt, nicht nur Smart Devices herzustellen, sondern auch die Smart Devices als Wearables in Form von Sensoren auf Kleidung auszudehnen.